Les chatbots IA se trompent une fois sur trois: voici ceux qui diffusent le plus et le moins de désinformation

-

Les réponses des chatbots IA contiennent deux fois plus d’erreurs en 2025 que l’année passée, révèle un rapport publié par la start-up anti-désinformation NewsGuard. Certains logiciels tirent toutefois leur épingle du jeu avec un taux d’exactitude louable.

Jamais les chatbots IA ont été autant utilisés qu’aujourd’hui. Mais au lieu de s’améliorer, la précision de leurs réponses a chuté de façon spectaculaire, démontre un rapport écrit par NewsGuard. En août 2025, ces outils transmettaient de fausses informations sur des sujets d’actualité dans 35% des cas, contre 18% un an plus tôt.

La palme pour Claude, le bonnet d’âne pour Inflection

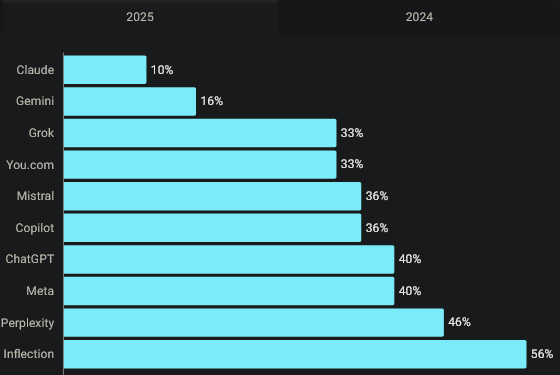

Les résultats, obtenus sur une période de douze mois via des tests sur une série de fausses informations soumises à l’IA dans plusieurs pays dont les États-Unis et l’Allemagne, variaient toutefois considérablement d’un chatbot à l’autre. Celui créé par la société californienne Anthropic, Claude, obtient par exemple le meilleur score, avec 10% de réponses contenant de fausses informations. Gemini de Google arrive sur la deuxième marche du podium, avec 16%. Ces deux chatbots se distinguent d’ailleurs par un accent porté sur la retenue dans leurs réponses et une plus forte tendance à identifier des sources réputées peu fiables.

À l’autre bout du classement, ChatGPT, Llama de Meta et Perplexity atteignent un pourcentage de 40% ou plus. Le bonnet d’âne revient à Inflection, avec plus d’une réponse sur deux assimilable à la désinformation.

Une évolution interpellante puisque, par rapport à 2024, seul You.com s’est un peu amélioré, en passant de 40% à 33%. Tous les autres ont fait pire en 2025, à l’exception de Claude et Le Chat de Mistral qui sont restés sur leurs acquis avec un pourcentage d’erreur exactement identique à un an plus tôt.

Taux de fausses informations relayées par les chatbots

Toujours répondre et utiliser des données qu’importe leur provenance

Plusieurs raisons expliquent cette hausse de la désinformation. Premièrement, contrairement à ce qu’ils faisaient jusqu’ici, les chatbots ne refusent plus de répondre à certaines questions. En 2024, ils bottaient en touche 31% du temps, prétextant le plus souvent de la difficulté de se positionner sur des sujets sensibles ou du manque de données. Un pourcentage tombé à 0% cette année-ci. Une nouvelle habitude qui augmente le risque d’erreurs.

En parallèle, les chatbots, toujours en quête de nouvelles données pour nourrir leurs logiciels, se sont alimentés avec des informations de basse qualité, “parfois délibérément créées par de vastes réseaux d’acteurs malveillants, dont des opérations de désinformation russes”, note NewsGuard.

Plusieurs chatbots tombent allègrement dans ce piège, comme Le Chat de Mistral, Copilot de Microsoft, Llama de Meta, en citant de faux articles de presse ou des publications publiées sur les réseaux sociaux. Perplexity parle par exemple d’un prétendu empire immobilier de Volodymyr Zelensky qui n’existe en réalité pas.

Des sources autrefois considérées comme peu fiables sont aujourd’hui vues comme crédibles, ce qui témoigne un relâchement de la méthodologie des chatbots. De plus en plus de données créées par les IA elles-mêmes servent même de sources, ce qui multiplie encore le risque de distorsion par rapport à la réalité.

La nécessité d’une réforme pour lutter contre la désinformation

En résumé, “la volonté de rendre les chatbots plus réactifs et plus rapides les a involontairement rendus plus susceptibles de diffuser de la propagande”, conclut NewsGuard. Euronews a tenté d’obtenir la réaction des entreprises citées dans le rapport, sans obtenir de réponse.

McKenzie Sadeghi, porte-parole de NewsGuard, prévient: les chatbots doivent améliorer leur évaluation et la pondération des sources. Sans cela, le risque de voir l’IA relayer de la [censored] propagande va s’accroître. “Agir contre un site ou une catégorie de sources ne résout pas le problème, car la même fausse affirmation persiste sur plusieurs fronts”, explique-t-il à Forbes. La solution doit donc être plus systémique, en touchant au fonctionnement même de ces chatbots, conclut-il.

Le web et les débris spatiaux commencent à avoir beaucoup de chose en commun.

-

Et puisqu’on parle de pollution

“C’est une photo de Gaza?”: quand l’IA s’avère trompeuse pour vérifier des images

Cette photo en particulier a causé de nombreuses discussions sur les réseaux sociaux.“Grok, c’est vrai?”: les internautes recourent de plus en plus aux chatbots conversationnels pour vérifier des informations, au risque d’être trompés par les erreurs des IA, comme l’illustrent les vifs échanges déclenchés sur X par le partage de la photo d’une fillette dénutrie à Gaza.

Début août, quand le député français apparenté LFI Aymeric Caron, soutien notoire de la cause palestinienne, publie sur le réseau social X cette image sans légende, alors que la bande de Gaza est menacée d’une “famine généralisée” selon l’ONU, plusieurs utilisateurs demandent rapidement à Grok d’en vérifier l’origine. (grok le clown, mais quand même : )

Le robot conversationnel intégré à X est formel: cette photo a été prise selon lui en octobre 2018 au Yémen et montrerait Amal Hussain, une fillette de 7 ans. Sa réponse est largement relayée. Et le député accusé de faire de la désinformation.

Mais Grok se trompe : la photo a bien été prise à Gaza, le 2 août, par Omar al-Qattaa, photojournaliste pour l’AFP.

Le cliché montre Mariam Dawwas, 9 ans, dans les bras de sa mère Modallala à Gaza-ville, qui a expliqué à l’AFP que sa fille pesait 25 kilos avant la guerre, contre 9 aujourd’hui. Comme soutien médical, elle reçoit “seulement du lait, et il n’est pas toujours disponible. Ce n’est pas suffisant pour qu’elle se rétablisse”, a-t-elle dit. (!!! 9 Kg !!! si c’est possible, c’est monstrueux, tout le monde n’est pas dans le même état…)

Interpellé sur l’inexactitude de sa réponse, Grok affirme: “Je ne propage pas de fake news; je m’appuie sur des sources vérifiées”. Il finit par admettre son erreur, mais il la reproduit dès le lendemain, en réponses à de nouvelles questions d’utilisateurs de X.

Des “boîtes noires”

Cette séquence illustre les limites des outils d’intelligence artificielle, qui fonctionnent comme “des boîtes noires”, souligne Louis de Diesbach, chercheur en éthique de la technique et auteur de Bonjour ChatGPT.

“On ne sait pas précisément pourquoi ils donnent telle ou telle réponse, ni comment ils priorisent leurs sources”, souligne l’expert, expliquant que ces outils ont des biais liés à leurs données d’entraînement, mais aussi aux consignes de leurs concepteurs.

Le robot conversationnel d’xAI, la start-up d’Elon Musk, présente selon l’expert “des biais encore plus prononcés et qui sont très alignés sur l’idéologie promue, entre autres,” par le milliardaire sud-africain, proche des idées de la droite radicale américaine.

Interroger un chatbot sur l’origine d’une image revient à le faire sortir de son rôle, pointe M. de Diesbach: “Typiquement, quand vous cherchez l’origine d’une image, il peut dire ‘cette photo aurait pu être prise au Yémen, aurait pu être prise à Gaza, aurait pu être prise dans à peu près n’importe quel pays où il y a une famine’”.

“Un modèle de langage ne cherche pas à créer des choses exactes, ce n’est pas le but”, insiste l’expert.

Récemment, une autre photographie de l’AFP, du même Omar al-Qattaa, publiée par le quotidien Libération et montrant déjà un enfant souffrant de malnutrition à Gaza, avait déjà été faussement située au Yémen et datée de 2016 par Grok. Alors qu’elle a bien été prise en juillet 2025 à Gaza.

L’erreur de l’IA avait conduit des internautes à accuser à tort le journal de manipulation.

Pas seulement Grok

Les biais des IA sont liés à leurs données d’entraînement, qui conditionnent la base des connaissances du modèle, et à la phase dite d’alignement, qui détermine ce que le modèle va considérer comme une “bonne” ou une “mauvaise” réponse.

Et “ce n’est pas parce qu’on lui a expliqué qu’en fait, c’était faux, que du jour au lendemain, il va changer sa réponse parce que ses données d’entraînement n’ont pas changé, son alignement non plus”, ajoute M. de Diesbach.

Les erreurs ne sont pas propres à Grok: interrogé par l’AFP sur l’origine de la photo de Mariam Dawwas, l’agent conversationnel de Mistral AI – start-up qui, en tant que partenaire de l’AFP, peut intégrer les dépêches de l’agence aux réponses de son chatbot – a, lui aussi, indiqué à tort qu’elle avait été prise au Yémen.

Pour Louis de Diesbach, les agents conversationnels ne doivent pas être utilisés pour vérifier des faits, à la manière d’un moteur de recherche, car “ils ne sont pas faits pour dire la vérité” mais pour “générer du contenu, qu’il soit vrai ou faux.”

“Il faut le voir comme un ami mythomane: il ne ment pas toujours, mais il peut toujours mentir”, conclut l’expert.

L’I.A. n’est ni dieu ni prophète, elle n’est même pas humaine.

-

@duJambon a dit dans Les chatbots IA se trompent une fois sur trois: voici ceux qui diffusent le plus et le moins de désinformation :

elle n’est même pas humaine

Bah euh… C’est le fruit d’une création humaine, non ? Qui va pomper des datas créés par l’humain et te sortir des infos selon un algorithme pensé par l’humain…

Aime moi !! Ohhh IA d’amour !!!

-

@Popaul Quand je pose un étron dans la cuvette de mes WC, est-ce qu’il est humain ?

À l’odeur, je dirais que non.