Accusé d’avoir contribué à vendre l’équivalent de plus de 105 millions de dollars de drogues sur le « dark web », un ex-étudiant taïwanais en sécurité informatique avait réussi à en tirer plus de 6 millions de dollars, à raison de 5 % de chaque transaction. Qu’il avait en partie transféré sur un compte à son nom.

Avec 45,5 millions de revenus en 2023, Incognito Market figurait alors en 4ᵉ position des places de marché du dark web les plus profitables. Le communiqué du département de la Justice US avance qu’elle aurait contribué à écouler plus de 105 millions de dollars de stupéfiants, dont plus de 1 000 kg de cocaïne, plus de 1 000 kg de méthamphétamines, des centaines de kg d’autres stupéfiants et plus de 4 kg d’une substance prétendument de l’« oxycodone », dont une partie était mélangée à du fentanyl.

« Rui-Siang Lin était l’un des trafiquants de drogue les plus prolifiques au monde, utilisant Internet pour vendre plus de 105 millions de dollars de drogues illégales dans tout le pays et à travers le monde », tout en prélevant 5 % des transactions, a déclaré le procureur américain Jay Clayton :

« Il est responsable d’au moins un décès tragique, et il a exacerbé la crise des opioïdes et causé la misère de plus de 470 000 consommateurs de stupéfiants et de leurs familles. La sentence prononcée aujourd’hui met en garde les trafiquants : vous ne pouvez pas vous cacher dans l’ombre d’Internet. Et notre message plus général est simple : Internet, la « décentralisation », la « blockchain »- toute technologie - ne sont pas un permis pour exploiter un commerce de distribution de stupéfiants. »

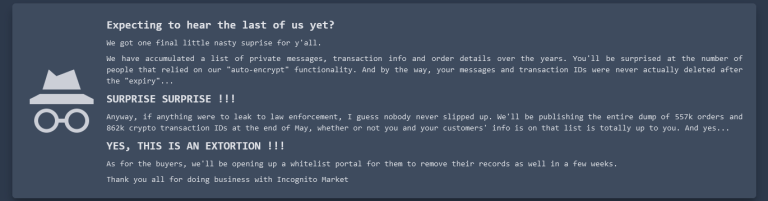

« Et oui, il s’agit d’une extorsion !!! »

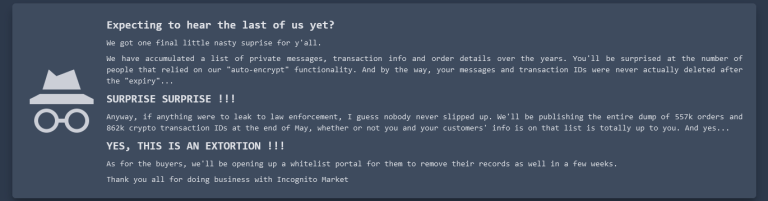

En mars 2024, Incognito Market, l’« une des plus grandes » places de marché (noir) de vente de drogues sur le dark web, parvenait successivement à escroquer puis rançonner ses utilisateurs. D’ordinaire, ceux qui procèdent à de tels « exit scam » cherchent à se faire discrets. Pharoah, l’administrateur de la place de marché, fit de son côté tout pour se faire remarquer.

Se disant « surpris du nombre de personnes qui se sont fiées à notre fonctionnalité de “chiffrement automatique” », Pharoah précisait en effet aux utilisateus d’Incognito Market que les « messages et identifiants de transaction n’ont jamais été supprimés après la période d’“expiration”… SURPRISE SURPRISE !!! »

Pour les inciter à payer leurs rançons (de 100 à 20 000 dollars), il menaçait même de « fuiter auprès des forces de l’ordre » l’intégralité des 557 000 commandes et 862 000 identifiants de transactions de crypto-monnaies à la fin du mois de mai : « Le fait que vos informations et celles de vos clients figurent sur cette liste ne dépend que de vous », précise le message : « Et oui, il s’agit d’une extorsion !!! ».

Un CV incompatible avec sa fortune en cryptos

Fin mai, le département de la Justice des États-Unis avait annoncé l’arrestation d’un Taïwanais de 23 ans, qu’il accuse d’être Pharoah. Rui-Siang Lin, un ex-étudiant en sécurité informatique passionné par les cryptos – et également connu sous les noms de Ruisiang Lin, 林睿庠, et faro – avait en effet été arrêté à l’aéroport John F. Kennedy de New York.

[…]

Article complet en accès libre : next.ink